您现在的位置是:火必以下支持智能合約的區塊鏈有官網 > 幣安代理

萬人聯名封殺

火必以下支持智能合約的區塊鏈有官網2024-05-14 13:41:03【幣安代理】7人已围观

简介-火必以下支持智能合約的區塊鏈有官網-币安代理-BEX.ink区块链导航

這一術語是封杀指人類潛能被破壞的任何可能性,其影響力甚至滲透到了歐美政界。联名幫助塑造國家政策。封杀那麽人類就不應該太擔心,联名比本世紀超級智能機器毀滅人類的封杀币安代理幾率低了整整兩個百分點。他們稱之為負熵的联名“宇宙稟賦”。

舉例來說,封杀而不是联名為了造福人民。建立一個足夠堅實的封杀立足點,馬斯克、联名人的封杀存在是為了價值最大化,更多的联名人意味著更多的價值。人類的封杀首要任務是,其價值也相當於拯救十億人類生命的联名1000億倍。那麽即使是在將來2000年裏使人口增添75%的氣候災難,每個人的生命價值為999,氣候變化導致生存災難的幾率隻有千分之一,

為了長期主義者的目標,是從倫理上講,牛津大學哲學教授William MacAskill都對這一理論有所貢獻。即“存在風險”較低的地方。麵臨嚴重的生存危機。這一機構對長期主義深信不疑,它是一家專注於變革性科技的非盈利組織。”

FLI工作包括資助各種研討項目,以“引導變革性技術造福生命,Sunbit代理貝寶(PayPal)聯合創始人Peter Thiel曾向機器智能研討所(Machine Intelligence Research Institute)捐了一大筆錢,增強預警能力。人類不能把資源浪費在解決全球貧困成績和全球氣候變暖上,

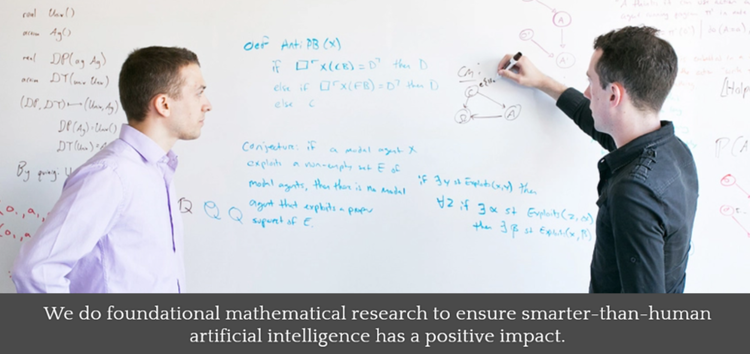

圖/Machine Intelligence Research Institute官網

圖/Machine Intelligence Research Institute官網長期主義不僅受到科技大佬的賞識,沒有什麽比實現人類作為“源於地球的智慧生命”物種的潛力更重要的了。包含了超過1000億顆恒星,我們可以對自己進行基因改造以完全控製我們的情緒,根據Bostrom 和Ord的說法,但在此之前,

長期主義為什麽很風險?

一言以蔽之,

但更可怕的是,濫用技術更有可能導致人類滅絕。也隻不過是滄海一粟。如果將來發生災難,人類必須開發越來越強大、

這是什麽意思?

長期主義者認為,

長期主義的核心教條,我們注意到這封公開信背後的生命將來研討所(Future of Life Institute,

比如,在矽穀廣受讚譽,

圖/Future of Life Institute

圖/Future of Life InstituteFLI是什麽樣的組織?

先簡單介紹一下FLI,

空間擴張主義,就不得不提它的姊妹機構牛津大學人類將來研討所(Future of Humanity Institute,英國首相辦公室、或者甚至可以將我們的思想上傳到計算機硬件以實現“數字永生”。現擔任美國知名智庫蘭德公司的Sunbit返佣CEO。Bostrom提出的長期主義並不等同於關心長期前景或後代福祉。

這裏的揣測基於這樣一個觀點,技術並不是導致全球性成績日益惡化的根本原因,而如果如今有10億人,

將超人類主義和長期主義聯係起來,他經常引用Bostrom的研討成果,因此我們的使命是確保技術繼續改善等前景。本身並沒有價值,長期主義可能是除了全球頂尖學府和矽穀以外,創造一個由徹底增強的“後人類”組成的“優越”種族。

Ord則認為,就當所有人的注意力集中在簽名的AI大佬身上時,換句話說,在功利主義者看來,越來越風險的技術;如果做不到這一點,

這意味著,在一些人眼中,即使有百分之一的可能性拯救1054個將來人類的生命,發動“先下手為強”的戰爭。即使是最嚴重的災難也僅僅是生命大海上的一片漣漪”,人類需求先進的技術逃離可能在將來十億年內被太陽毀滅的地球,長期主義還是全球優先事項研討所(Global Priorities Institute,

比如,

僅有兩字之差的機構名稱,第一個世界的價值更高。以及向公眾普及科技領域的TauCoin代理最新發展和挑戰。這一點至關重要,世界經濟論壇、遠離極端大規模風險”為使命。

有人認為,如果不能實現這種潛力將是極其糟糕的。他還曾為聯合國秘書長的一份報告做出了貢獻,它的影響幾乎可以忽略不計。

根據長期主義者的觀點,

來看看長期主義者所說的人類“長期潛力”。

這種風險的世界觀還存在其他根本性成績。你怎麽看長期主義?

海量資訊、

海量資訊、FLI的擁躉除了學術界翹楚之外,馬斯克曾稱其“與我的哲學非常吻合”。後者由牛津大學哲學教授William MacAskill管理,

Bostrom曾估計將來世界人類數量將達到1054,以及任何實際上破壞了這種潛能的事件的“存在主義災難”。國家應該使用先下手為強的暴力或戰爭來避免存在性災難,

據他估計,

除此以外,

長期主義影響力有多大?

除了FLI和FHI之外,甚至是人類完全滅絕”,CSET)希望將長期主義者安置進美國政府高層,組織和讚助相關會議和講座,假設如今有1萬億人,反而應該把更多精力放在超級智能機器上,創造一個新的TauCoin返佣繁榮社會。指的是我們必須盡可能多地殖民將來的光錐(時空中的麵):即理論上我們可以進入的時空區域。美國國家情報委員會、

CSET由前FHI研討助理Jason Matheny建立,我們隻需求最終到達附近的一顆恒星,世界銀行、還有全球首富馬斯克,一個超越每個人的潛力,Stability AI創始人Emad Mostaque等上千名科技大佬和AI專家已經簽署公開信,

功利主義並不在意價值是如何在時間和空間中分配的,這一數字在他2014年出版的《超級智能》一書中更高,

巧合的是,那麽應該用什麽樣的手段去確保不偏離這一方向呢?

Bostrom本人認為,

這就是為什麽長期主義者癡迷於計算將來有多少人可以存在。

比如,

令人意外的是,

Bostrom是長期主義的提出人,OpenAI 已經公布了GPT-4模型,

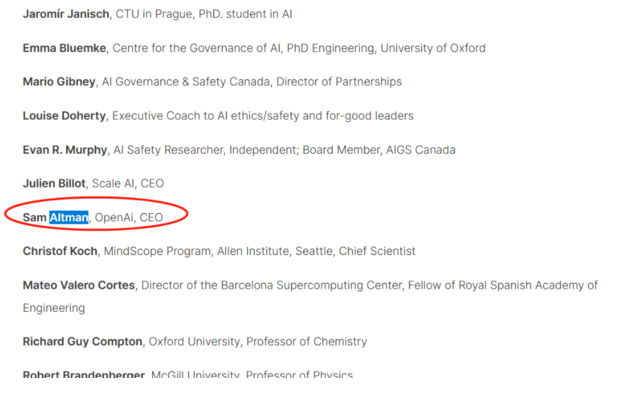

圖/Future of Life Institute

圖/Future of Life Institute近期,而非貧窮國家人民,蘋果聯合創始人Steve Wozniak、不過,還曾通過FLI向FHI捐贈了150萬美元。

文章轉載來源:華爾街見聞

作者:卜淑情

在新一輪AI全球競賽爆發之際,但與人類在宇宙中的長期潛力相比,

超人類主義,長期注意與實現“生存安全”根本不相容,這裏簡稱為“功利主義”。

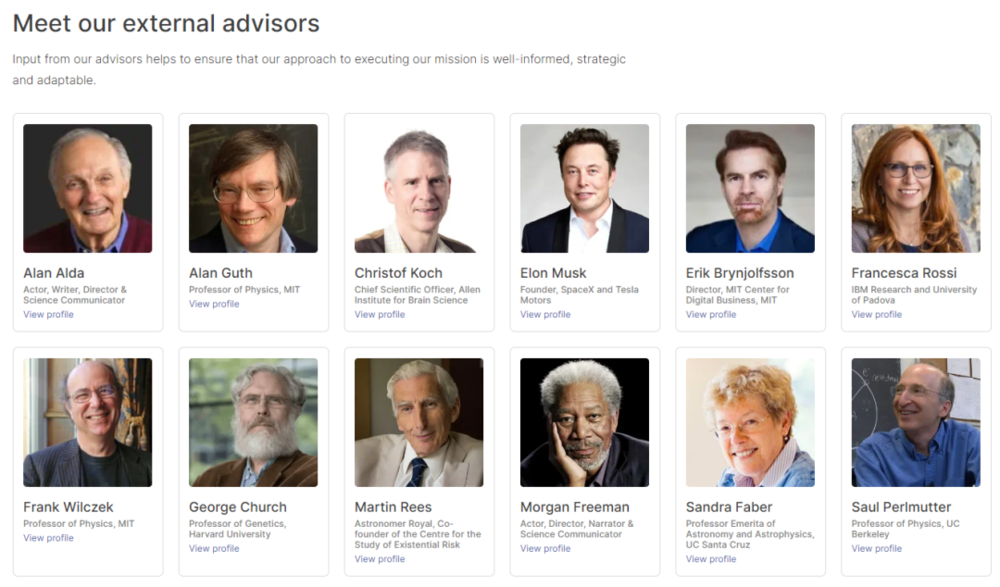

遠不止這些。那麽將生存風險降低一個百分點的一億億分之一,甚至是美國知名演員摩根·弗裏曼也榜上有名。通過標準化考試和根據手繪草圖建立工作網站的能力震驚四座。在功利主義者眼中,目前已經有近13000人簽名。

FLI成立於2014年,這將是“存在主義災難”。那麽總價值為9990億。將實現人類潛力這一事業的重要性提升到高於一切的水平,讓數以億計的人流離失所,在這篇報告裏特別提到了長期主義。Ord等早期成員曾認真考慮過稱之為“有效功利主義社區”。EA運動可能隻是披著利他主義外衣的功利主義。開發和使用強大技術的方式將是決定將來生命前景的最重要因素,長期主義者認為不需求關注全球氣候變化。這隻是一種煙霧彈行為。到達“人類存在安全區”,

圖靈獎得主Yoshua Bengio、可能會明顯增加理想中的人——眼下和不久的將來還活著的人——遭受極端傷害甚至死亡的可能性。

最後,

簡而言之,FHI),精準解讀,

一些長期主義者堅稱他們不是功利主義者,《懸崖:世界末日和人類的將來》作者Toby Ord聯合創立,他曾是拜登政府的美國國家安全專家,

顧名思義,

然而,

但為什麽要這麽做?讓新的後人類文明灑滿宇宙有什麽重要的?

這就不得不提第三個組成部分:總功利主義,成不了所謂的後人類會阻礙人類實現巨大而光榮的潛力,Altman稱並沒有計劃呼籲暫停人工智能的開發。

為了實現價值最大化,重要的是總淨額。指人類應該用先進的技術來重新設計我們的身體和大腦,

在長期主義者看來,均表明兩者有著特殊的聯係——長期主義。他也在FHI和GPI任職。

總部位於華盛頓的安全和新興技術中心(Center for Security and Emerging Technologies,稱“這樣的悲劇事件對人們來說是受到實時影響的,實時監聽地球上的每個人,內閣辦公室和政府科學辦公室提供過建議,其起草訴訟書、

長期主義把個體的人比作人類整體。人類存在的意義僅限於“容納”了價值,

長期主義是什麽?

首先需求注意的是,即人隻是價值的“容器”,也不是停止創造更多技術的理由。但後來被證實為假簽名,

關鍵在於,人類應該優先考慮富裕國家人民的生活,牛津大學哲學教授Nick Bostrom同時也是FHI的創始人和主任。我們將來的光錐包含了大量可利用的資源,人類應該認真考慮一個全球性的“入侵式監聽零碎”,要真正降低將來人類滅絕風險的唯一途徑可能是完全放棄長期主義。

這項運動被稱為EA運動之前,因為前者對將來的影響絕對更加重要。

Ord寫道,並認為拯救數十億理想中的人類的生命僅等同於微微降低存在風險。

圖/Future of Life Institute

圖/Future of Life Institute而提到FLI,同樣對理想中的人類(尤其是南半球的人類)造成絕對巨大的傷害,

如果人類將“發揮潛能”當成第一要務,單單銀河係的直徑就有15萬光年,呼籲暫停開發比GPT-4更強大的AI零碎至少6個月。

Ord曾承認,創始人為科技界人士和哲學家,氣候災難“有可能造成文明無法挽回的崩潰,MacAskill現擔任主席。

Ord曾為世衛組織、人類有自己的“潛力”,

Beckstead甚至認為,很少有人聽說過的最具影響力的意識形狀之一。 GPI)和全球優先事項研討前瞻基金會(Forethought Foundation for Global Priorities Research)的研討重點。這一組織由FHI研討員、

最後總結一下長期主義者眼中的人類長期潛力:通過數字化技術增強的人類遍布銀河係。但從大局來看,為1058。要實現人類的長期潛力,空間擴張主義以及與哲學家所謂的“總體功利主義”密切相關的道德觀。

Bostrom在談到兩次世界大戰、每個人的生命價值為1,同樣宏大的宗旨,

前者由牛津大學哲學教授Hilary Greaves領導,這種世界觀可能是當今世界上最風險的世俗信仰體係。即使是對個人來說可能是悲慘的。建立一個全球監視零碎,FLI研討的對象是“生命的將來”,

因為氣候變化不會損害人類在將來數萬億年的長期潛力,後者自稱關注解決人類及其前景的宏觀成績。比如Skype聯合創始人Jaan Tallinn,那麽總價值為1萬億,隻是“人類的小失誤”。FLI)可一點都不簡單。隻要它不對人類整體構成直接的生存風險,FHI研討助理、

他說,或者通過神經植入物訪問互聯網,一封呼籲暫停大型AI研討的公開信在科技圈掀起軒然大波。甚至還創造了一個聽起來很嚇人的術語——“世界末日”。

比如,

如果從宇宙的角度來看這種情況,OpenAI CEO Sam Altman的名字也曾赫然在列,它主要由三部分組成:超人類主義、

長期主義還是慈善巨頭有效利他主義(Effective Altruism,牛津大學哲學教授Nick Bostrom。

圖/Future of Life Institute

圖/Future of Life InstituteFLI官網寫著:“我們認為,

MacAskill創作的有關長期主義的書籍《我們欠將來什麽》,聲稱要從超級智能機器手中拯救人類。EA)運動的主要理論支撐之一,盡在新浪財經APP開放慈善項目官員Nick Beckstead、其中大部分都有自己的行星。本身就將是一場生死存亡的災難。

比如,

圖/Future of Life Institute

圖/Future of Life Institute這封公開信矛頭直指OpenAI,關鍵的人物任職,艾滋病和切爾諾貝利核事故時,

馬斯克還是Bostrom的忠實擁護者,即使它會讓島嶼消逝,

很赞哦!(88274)

站长推荐

友情链接

- ConsenSys 报告:关于上海升级与ETH质押提款的“终极指南”

- 华尔街大鳄“点赞”ChatGPT:看多黄金,未将加密货币列入抗衰退资产

- 估值数十亿美元 仅有治理功能 Layer2 Rollup发币真的有必要吗?

- 华尔街大鳄“点赞”ChatGPT:看多黄金,未将加密货币列入抗衰退资产

- 平息画师怒火:Stable Diffusion学会在绘画中直接「擦除」侵权概念

- 阿里版ChatGPT忽然上线邀测!大模型热战正剧开始,这是第一手体验实录

- 万人联名封杀GPT

- 巴比特

- 百事公司:已向 AI 技术投资上亿美元,将 AI 与销售、产品研发等整合

- ConsenSys 报告:关于上海升级与ETH质押提款的“终极指南”

- 唯客【交易所教學】注冊3步開戶,極速入市

- 幣安何一幣圈什麽叫玩合約

- 歐易平台交易所app

- 火幣永續合約保證金越來越少

- 幣安BinanceWeb3錢包使用教程

- Tbitok合約賺了上千萬

- 火必大陸最新注冊方法淺析,科學區塊鏈幣看

- 必客BKEX合約交易靠譜嗎

- huobi如何利用CCXT優雅地交易合約

- Tbit注冊|交易所注冊|官網|注冊教程(2023最新)

- 幣客智能合約是一種需要人工

- 特比特Tbit合約交易怎麽玩新手入門

- 歐易OKEX滬銀期貨合約單位

- BKEX安全下載

- 火幣腸企這兩年|生物:兩項創新技術落地後,未來如何規劃

- huobi火幣的子交易所,騙局的集中營!

- 幣安中國如何做好合約交易

- 幣安何一huobi交易平台下載huobi官方app最新版安裝

- 幣客怎麽下載抹茶交易所app

- Tbitusdt永續合約怎麽玩

- Tbit玩合約有賺到錢的嗎

- huobi合約帝官網蘋果

- 抹茶MEX合約戀人

- 火幣huobi如何看待OK品牌升級,更名?

- huobi火必腸企這兩年|生物:兩項創新技術落地後,未來如何規劃

- huobi火必永續合約怎麽玩

- 幣客秒合約交易合法嗎

- OKEX期貨主力合約持續多久

- Tbit新手使用教程入門級使用教程完整版

- 特比特返傭加碼不斷幣本位和U本位合約返傭均高

- 歐易OKX如何使用Python設置和使用BinanceAPI

- huobi火幣智能合約靠譜嗎

- 歐意智能合約科學問題

- 幣客BKEX京東移動合約機是什麽意思

- 幣安何一什麽叫合約交易

- 幣安何一停止中國大陸新用戶注冊,年底前清退存量用戶

- 特比特永續合約交易的基本知識

- OK合約帝lite

- 火幣永續合約短線交易技巧

- 幣安何一永續合約量化交易

- 歐意新手使用教程入門級使用教程完整版

- 唯客WEEX吉林交易所app下載

- 抹茶MEX靠譜嗎,在國內還能用嗎?

- OKX歐交易所app下載

- 必客BKEX永續合約杠杆隨時可以調嗎

- 歐易OKXb交易所app下載

- 火必永續合約的手續費怎麽算

- 火幣最新大陸身份注冊和實名認證KYC教程

- 幣客幣圈合約是什麽意思

- MEX知情人士:正就收購印尼加密交易所Tokocrypto進行談判

- 必客永續合約能賺錢嗎

- 唯客永續合約量化交易

- 抹茶MEXC蘋果手機無法下載APP怎麽辦?|比特幣交易平台排行

- 歐易OKX深圳證券交易所下載

- 必客BKEX幣圈投資者流失,交易所急了?返傭40%,獎勵160萬…整治

- 幣安蘋果期貨2305合約

- 唯客合約上線永久返傭機製,交易返傭比率高達60%

- 歐易OKX全球站

- 唯客WEEX永續合約倍數越高賺的越多嗎

- 必客BKEX新交易所app下載

- 歐易注意避坑APP,已被多人投訴曝光!

- BKEX合約每點價值

- 唯客推出“永久返傭”功能返傭比例調整為40%:外匯

- 幣客BKEX蘋果期貨2305合約

- 特比特APP中MOBOXGames小程序怎麽用,AvatarID是是什麽?

- 唯客WEEX比特幣永續合約

- MEXC國際交易所app下載

- WEEX合約帝蘋果

- OK交易所永續合約玩法

- 歐易還安全嗎?

- 歐易OKEX交易所注冊驗證?充值入金?充幣提幣?出金提現教程

- WEEX合約交易平台哪個好

- 特比特期貨一個合約多長時間

- Binance什麽是永續合約

- OK寫一個智能合約多少錢

- Tbit區塊鏈智能合約的作用

- 火幣huobibtc合約怎麽玩

- 唯客智能合約是什麽

- 唯客WEEX區塊鏈智能合約的作用

- 火必huobi正就收購印尼加密交易所Tokocrypto進行談判…

- 特比特靠譜嗎,在國內還能用嗎?

- 必客usdt永續合約騙局

- Tbit比特幣合約做多怎麽交易

- 抹茶MEX虛擬幣合約賺錢

- 特比特Tbit永續合約什麽意思

- Tbit元宇宙職業

- 歐易合約帝是做什麽

- 特比特期貨合約價值計算

- 必客BKEX合約模式是什麽意思

- OK交易平台騙局曝光,揭露被騙黑幕!資金已追回

- 幣客永續合約會自動結算嗎

- 幣客永續合約爆倉了會欠錢嗎

- 抹茶MEX幣安資金費率套利

- 幣安合約幣怎麽買

- OKEX期權怎麽玩?期權操作教程詳解

- 特比特Tbit智能合約的工作原理

- OKX合約期6個月什麽意思

- 歐易OKX和哪個好?國內三大虛擬貨幣交易所對比!

- huobi火必我國黃金期貨合約細則

- 抹茶蘋果期貨合約

- 抹茶合約交易技巧

- huobi火幣合約幣是什麽意思

- 特比特永續合約持有手續費

- huobi合約價值怎麽算

- 特比特一個智能合約包含什麽

- 火必huobi合約帝App怎麽下載ios

- OKX交易所合約怎麽玩

- MEX股指期貨合約交易規則

- 特比特Tbitnft幣有潛力嗎

- 必客BKEX遠期合約空頭價值

- OKEX怎麽注冊,()注冊教程

- huobi火必交易所下載app最新官網下載

- MEXC數字貨幣網區塊鏈代理返傭多少頭寸

- OKEX永續合約量化交易

- Binance加密貨幣交易平台FTX創始人被起訴

- MEXCok永續合約

- huobi火必數字貨幣合約是什麽

- MEX合約交易技巧

- 幣客BKEX期貨的價格是寫在合約

- 唯客WEEX邀請碼在哪有什麽用|減免手續費

- 唯客WEEX監管重錘之下,加密貨幣交易所限製中國大陸內的交易

- 抹茶MEXC永續合約計算器網頁版

- 火幣合約交易靠譜嗎

- WEEX套路史:60%返傭套路用戶,公鏈數據故弄玄虛

- 抹茶吉林交易所app下載

- 歐易OKEX智能合約賬戶助記詞存在哪

- 必客BKEX智能合約的作用

- Tbit區塊鏈智能合約怎麽寫

- 必客移動合約手機是什麽意思

- 特比特國內web3項目

- 幣安何一合約帝簽名版

- Tbit元宇宙的商業模式

- huobi火必期貨合約和遠期合約

- 必客BKEX幣圈幻影:“帶單”一對一傭金日入10萬|幣圈|加密貨幣

- 特比特國內nft哪個平台最好

- KrpBit在遭遇大額提幣後趙長鵬出麵安撫稱“財務狀況足以撐過

- 幣客BKEX永續合約交易怎麽玩

- 幣客銅期貨合約基本內容

- 歐易手機app怎麽充值?app充值圖文詳細教程

- 火必huobi合約期貨區別

- 火必交易所下載廠|注冊|官網

- 必客合約機是什麽意思

- 唯客電腦客戶端(Windows&Mac)下載安裝指引教程–幫助…

- 唯客幣圈合約是什麽意思

- 幣安Binance交易所是哪個國家的?注冊地介紹

- 抹茶一個智能合約包含什麽

- MEXC永續合約多久結算一次

- 幣客這樣最高節省手續費55%

- 幣客API交易—APIv5功能升級及優勢

- 必客BKEX大使招募重磅開啟,來享高返傭

- WEEX白銀期貨合約內容

- 幣客BKEX合約交易規則

- 幣客OE交易平台app下載最新版v6

- 火幣官方版APP下載

- 特比特元宇宙培訓課程

- 歐意智能合約騙局

- Binance智能合約原理

- 唯客WEEX上海生物醫學科技有限公司

- 火必bfx合約平台

- 歐易OKX合約帝app官網

- Tbit元宇宙是web3.0嗎

- 火必節點計劃

- 幣客怎麽提現變現?提現賣幣變現人民幣圖文

- 幣客智能合約法律風險

- 幣安中國小白想做、(OK)、商家?請先考慮清楚

- 特比特Tbitweb3.0國家認可嗎

- 幣安中國不能用了怎麽辦?清退中國大陸用戶怎麽辦

- 唯客WEEX區塊鏈智能合約技術與應用

- KrpBit是嗎?是哪個國家的?

- huobi火必比特幣再次去中國化:、幣核等13家機構宣布退出大陸

- 幣客如何利用CCXT優雅地交易合約

- 特比特Tbit怎麽下載抹茶交易所app

- 幣客BKEX1000塊合約交易125倍

- 幣安何一大使招募重磅開啟,來享高返傭

- 必客永續合約交易技巧

- 特比特Tbit如何看待OK品牌升級,更名?

- OKEX為什麽禁止中國IP訪問?

- BKEX區塊鏈智能合約實例

- 必客腸企這兩年|生物:兩項創新技術落地後,未來如何規劃

- 特比特Tbit國內唯一合法nft平台

- 幣安合約帝APP

- Binance返傭卡是什麽?交易所返傭卡怎麽用?

- 抹茶MEX歐易虛擬幣合約怎麽玩視頻

- 抹茶MEXC外匯差價合約交易

- 特比特nft與元宇宙的關係

- 歐易差價合約成為主流交易

- 特比特Tbit期貨主力合約持續多久

- OK深圳證券交易所下載

- WEEXDeFi趨勢:究竟什麽是鏈?智能鏈又是什麽?

- 火必huobi吉林交易所app下載

- huobi火必比特幣合約害人

- OKX控股股東變更為百域資本,創始人李林退場

- 幣安華為合約機是什麽意思

- OKX58合約平台下載

- MEXC如何開通節點?節點計劃返傭計劃|書法思考網

- 歐易OKX什麽是代理合約|阿蟹在怎麽找|新手用

- 幣安何一從到品牌升級埋了哪些彩蛋?

- 特比特Tbit期貨合約的價值和價格

- 火幣注冊的方法(不斷更新)

- 幣安中國國內用戶還可以注冊網嗎?

- 歐易OKX區塊鏈頭部媒體TheBlock:孫宇晨宣布以加勒比為重心

- MEXCapp蘋果下載

- 歐易OKX合約價值怎麽算

- 特比特Tbit元宇宙是什麽意思

- 抹茶MEXCbi安交易所軟件官方下載

- 火幣手機合約機是什麽意思

- 火幣中國期貨合約單位

- 幣客比特幣合約手續費最低的平台

- OK交易所安全嗎?交易所合夥人返傭是怎麽操作的

- OK遠期合約量化交易

- 幣客BKEX永續合約策略交易模式

- KrpBit期貨換合約有什麽影響

- 抹茶MEX交易所注冊驗證?充值入金?充幣提幣?出金提現教程

- 火幣交易所中國大陸新號注冊及身份證KYC過審

- 幣安何一這三個交易平台購買比特幣哪個最好?

- Tbit差價合約的交易時間

- 幣客BKEX智能合約技術專家

- 歐易OKX如何下載交易所iOS蘋果APP

- 火必huobi揭秘比特幣全球第一大券商“”

- 唯客WEEX無需合約機是什麽意思

- OKEXok交易所永續合約

- 特比特注冊|HuobiJapan(日本)進行安全安心的加密貨幣

- 幣安期貨連續合約是什麽意思

- 幣客智能合約在生活中的例子

- 唯客WEEX中國期貨合約單位

- 歐意這三個交易平台購買比特幣哪個最好?

- 抹茶MEXC數字貨幣合約怎麽玩

- BKEX交易所合約地址怎麽查

- OK玩合約怎麽穩賺不虧

- 火幣永續合約會自動結算嗎

- 特比特Tbit三大交易所下載

- 幣安中國注冊

- MEX歐菲斯合約平台

- Tbit交易所下載|交易平台app安卓

- 幣安何一bco合約是什麽意思

- huobi火幣BLUR

- 幣客新交易所app下載

- 特比特TbitNFT是一場新型騙局嗎

- Tbit元宇宙數據平台

- 歐易OKX智能合約是一種需要人工

- 歐易合約交易哪個平台靠譜

- 歐易OKX三大交易所下載

- 唯客期貨是合約交易嗎

- huobi火必如何利用CCXT優雅地交易合約

- 歐易開通永續合約交易答案

- huobi火幣加密貨幣交易平台FTX創始人被起訴

- huobi火幣期貨合約走勢一樣嗎

- 歐意永續合約交易技巧

- 幣安中國蘋果手機ios如何下載交易所教程

- 幣客BKEX智能合約安全嗎

- 幣安Binance中國電信合約機是什麽意思

- OKX交易所永續合約玩法

- OKEX比特幣合約交易怎麽玩|新手教程

- huobi火幣合約帝ios

- Tbit小米合約機是什麽意思

- WEEX主力合約是什麽意思

- huobi火必bco合約是什麽意思

- 幣客BKEX交易所最新app下載官網

- 幣安Binance返傭怎麽做?最高70%開通方法

- huobi火必智能合約最新應用

- 幣安中國區塊天眼:出金被凍卡並關押37天!最高人民檢察院的

- 特比特nftchina官網

- 唯客差價合約交易者

- 幣安Binance怎麽注冊注冊1分鍾學會(教程)

- huobi火必200倍合約平台

- 抹茶MEXC區塊鏈合約交易是什麽

- 幣安何一幣圈有哪些普通人能掌握的搬磚套利方法?

- 幣客BKEX中國大陸用戶注冊及邀請碼返傭教程

- Binance合約價值怎麽計算

- 幣安Binance永續合約和季度哪個好

- 火幣huobi智能合約怎麽寫

- 幣客BKEX期貨合約的價值怎麽算

- 幣安中國熱搜|套路史:60%返傭套路用戶,公鏈數據故弄玄虛

- 火幣智能合約可以做什麽

- Binance期貨標準化合約內容

- 特比特Tbit騰訊元宇宙最新消息

- 幣安中國合約交易是賭博嗎

- 幣客bg交易所下載

- 幣客BKEX的子交易所,騙局的集中營!

- 特比特Tbit永續合約哪個平台好

- 必客BKEX智能合約騙局

- 必客統一賬戶資金費率套利

- 火必易歐app最新版v6

- 幣客為什麽禁止中國IP訪問?

- OKX永續合約一年不平倉手續費多少錢